« Diagnostic différentiel ! ». Ces deux mots claquent comme un ordre dès que le Dr House s’adresse à son équipe face à un cas clinique complexe. Dans chaque épisode de la célèbre série, tout repose sur ce rituel : écrire au tableau blanc la liste des signes et symptômes, puis celle des maladies possibles, les discuter, en écarter certaines, en prioriser d’autres, jusqu’à formuler l’hypothèse la plus plausible. Le tout en tenant compte de la symptomatologie, de l’histoire de la maladie (anamnèse), des résultats biologiques, des données de l’imagerie, ainsi que des antécédents personnels et familiaux. C’est cette approche, à la fois rigoureuse et déductive, qui structure le raisonnement diagnostique de tout clinicien.

Mais que se passerait-il si, au lieu d’animer une réunion d’internes surdoués et de médecins expérimentés, le célèbre médecin diagnosticien se faisait assister par une intelligence artificielle pour établir le diagnostic différentiel ?

Dans la première partie de ce billet, j’ai évoqué une étude illustrant concrètement la confrontation entre un clinicien et une IA, engagés dans un fascinant duel de raisonnement médical. J’ai ensuite rapporté une seconde étude montrant comment une IA peut être entraînée à raisonner à partir d’un siècle de cas médicaux authentiques.

De l’imitation à la collaboration : AMIE et le diagnostic différentiel

Mais entre imiter la démarche d’un médecin et raisonner à ses côtés, il y a un monde. C’est précisément ce que deux études expérimentales, publiées dans la revue Nature en avril 2025, ont entrepris d’explorer : comment transformer une intelligence artificielle capable de rédiger un raisonnement médical en un outil collaboratif, apte à assister, stimuler ou compléter la réflexion du clinicien.

Pour cette expérimentation, les chercheurs se sont appuyés sur les célèbres Case Records of the Massachusetts General Hospital, publiés depuis un siècle dans le New England Journal of Medicine (NEJM). Ces conférences clinico-pathologiques (CPC), véritables modèles d’enseignement du raisonnement médical, présentent des cas souvent déroutants, exigeant une analyse fine et une hiérarchisation rigoureuse des hypothèses. Les CPC sélectionnées couvraient les principales spécialités : médecine interne, neurologie, pédiatrie et psychiatrie.

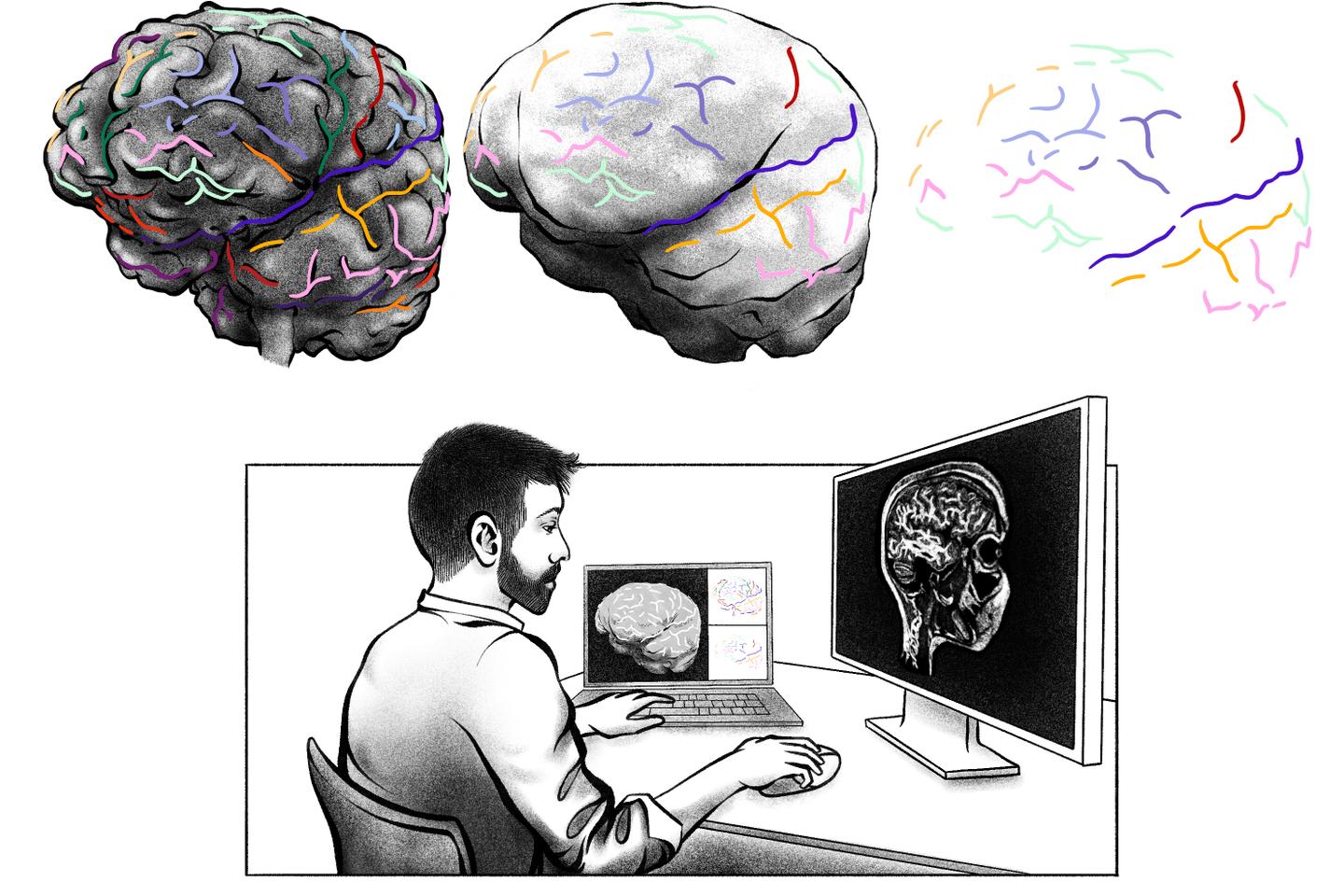

Vingt cliniciens, dont l’expérience professionnelle était en moyenne de plus de onze ans, ont été invités à évaluer 302 cas médicaux complexes. Chaque cas a été lu par deux cliniciens distincts, chacun placé dans une condition expérimentale différente. Dans la première, le médecin disposait uniquement des ressources classiques : moteurs de recherche et bases de données médicales (UptoDate, Google Search, PubMed). Dans la seconde, il bénéficiait en plus de l’assistance d’AMIE, pour Articulate Medical Intelligence Explorer, un modèle d’intelligence artificielle développé par les firmes Google Research et Google DeepMind et spécialement conçu pour le raisonnement diagnostique.

Tous les participants ont d’abord dû proposer, sans aucune aide, un diagnostic différentiel de départ, avant de répéter l’exercice avec les outils mis à leur disposition. L’objectif : comparer la qualité, la justesse et la richesse de leurs diagnostics, avec ou sans assistance de l’intelligence artificielle.

Chaque modèle d’IA a reçu le même scénario : lire un cas clinique complet, établir un diagnostic différentiel, classer les hypothèses par ordre de probabilité et expliquer son raisonnement. Les résultats ont ensuite été comparés à ceux des médecins et au diagnostic final.

L’étude s’appuyait sur une mesure simple et parlante : la top-10 accuracy, c’est-à-dire la proportion de cas où le bon diagnostic figure parmi les dix premières propositions. Cet indicateur évalue à la fois la justesse du raisonnement et son amplitude, c’est-à-dire la capacité à « penser large » avant de restreindre le champ des hypothèses.

Les grands modèles de langage (large language models ou LLM) reposent sur un principe statistique : ils apprennent à prédire la suite la plus probable d’un texte après avoir été entraînés sur des milliards de mots issus de la littérature médicale, d’articles scientifiques et de dialogues cliniques. Ce processus leur permet d’associer symptômes, maladies et traitements, mais sans véritable compréhension de la physiopathologie, autrement dit des mécanismes à l’origine de la pathologie dont souffre le patient.

L’IA ne voit pas, n’écoute pas, ne palpe pas le patient : elle ne raisonne pas par causalité mais par association de probabilités. En intelligence artificielle, le raisonnement est un processus consistant à utiliser les informations disponibles pour générer des prédictions, faire des inférences, c’est-à-dire à reconnaître des schémas et émettre des conclusions à partir de données que le modèle n’a jamais vues auparavant.

Ainsi, à partir de phrases décrivant un patient fébrile et ictérique, il peut inférer une liste de diagnostics possibles en mobilisant les régularités observées dans des milliers d’exemples similaires. Ce mécanisme de prédiction du texte lui permet de simuler un raisonnement, même si, en réalité, il ne raisonne pas : il associe des mots et des contextes, plutôt qu’il ne déduit des causes.

Le grand modèle de langage AMIE a été entraîné non seulement sur des textes médicaux, mais aussi sur des dialogues cliniques simulés entre médecin et patient. Il est conçu pour dialoguer activement avec les cliniciens et produire un raisonnement structuré. Cette approche interactive lui permet de formuler des hypothèses, de poser des questions et de réviser son raisonnement.

Là où GPT-4 se contente de générer du texte, AMIE imite la dynamique d’un échange médical : il pose des questions, reformule, justifie.

Des performances supérieures à celles des médecins non assistés

AMIE a obtenu une top-10 accuracy comparable à GPT-4 (autour de 85 %), mais s’est distingué par la pertinence de ses explications : ses justifications étaient plus structurées, plus proches de la démarche humaine.

Lorsqu’il travaille seul, sans intervention humaine, le modèle AMIE a obtenu une précision du diagnostic, ou top-10 accuracy, de 59 %. Cela signifie que dans près de six cas sur dix, le bon diagnostic figurait parmi les dix premières propositions formulées par la machine. La top-10 accuracy des cliniciens qui avaient eu recours à une assistance était, elle, de 51,8 %. La performance obtenue par l’AMIE seul dépasse nettement celle des cliniciens travaillant sans assistance, qui atteignait 33,6 % dans les mêmes conditions.

Autrement dit, l’IA double presque la performance humaine en matière de raisonnement diagnostique global. Ce résultat, statistiquement significatif, montre que la machine, livrée à elle-même, est déjà capable de reproduire une démarche clinique pertinente dans des cas particulièrement complexes.

La performance en termes de top-1 accuracy (diagnostic principal placé au premier rang de la liste), a été de 29,2 % pour AMIE seul, contre seulement 15,9 % pour les cliniciens non assistés et 25,2 % pour les médecins assistés par AMIE.

« Nos travaux prolongent de précédentes observations en montrant non seulement que l’AMIE était plus susceptible d’aboutir à une réponse correcte ou de fournir la bonne réponse dans une liste, mais aussi que ses diagnostics différentiels étaient jugés, par un évaluateur indépendant, plus pertinents et exhaustifs que ceux produits par des médecins certifiés ayant accès à des références et à des outils de recherche », font remarquer Daniel McDuff, Mike Schaekermann, Jake Sunshine, Vivek Natarajan et leurs collègues.

Ces performances ont été obtenues malgré le fait que l’AMIE n’avait accès qu’au texte relatant des cas cliniques, alors que ceux présentés aux cliniciens comprenaient des images et des tableaux. Bien que l’AMIE ait obtenu de meilleurs résultats que les cliniciens malgré cette limitation, on ignore si cet écart se creuserait, et dans quelle mesure, s’il avait également accès aux figures et aux tableaux.

L’IA améliore le degré de pertinence du diagnostic

Mais l’intérêt d’AMIE n’est pas seulement de raisonner seul : c’est surtout d’aider le médecin à raisonner mieux. Les chercheurs ont donc comparé les diagnostics établis par les cliniciens dans trois situations : sans assistance, avec l’aide d’un moteur de recherche, ou avec l’aide combinée d’AMIE et de ressources en ligne.

Résultat : la qualité moyenne des diagnostics a été significativement plus élevée chez les cliniciens assistés par AMIE. Leur top-10 accuracy atteignait 51,8 %, contre 33,6 % pour les médecins sans assistance et 44,5 % pour ceux aidés uniquement par la recherche en ligne. Lorsque l’AMIE intervenait seule, ce chiffre atteignait 59,1 %.

Ces différences traduisent une amélioration nette et reproductible du raisonnement clinique lorsque l’IA intervient. Ainsi, les médecins raisonnent plus juste lorsqu’ils dialoguent avec AMIE que lorsqu’ils travaillent seuls ou se contentent de chercher des informations en ligne.

Avec l’aide d’AMIE, les cliniciens ont listé en moyenne 7,6 diagnostics différentiels, contre 6,9 lorsqu’ils utilisaient la recherche classique et 6,4 sans aucune assistance. Or la longueur de ces listes reflète la diversité des hypothèses diagnostiques envisagées. L’assistance par AMIE a donc permis d’élargir un peu le spectre des hypothèses diagnostiques proposées par les médecins.

Les médecins ayant utilisé AMIE ont mis en moyenne 7,29 minutes pour établir leur diagnostic différentiel, un temps quasiment identique à celui observé lorsqu’ils effectuaient leurs propres recherches en ligne : 7,19 minutes. Ce résultat est d’autant plus notable qu’on pouvait s’attendre à ce que les cliniciens soient plus rapides en recourant à leurs méthodes habituelles de recherche sur Internet qu’ils pratiquent et maîtrisent depuis longtemps. Le fait qu’AMIE n’ait pas ralenti leur démarche diagnostique suggère que le système s’est intégré de manière fluide à leur démarche, malgré la nouveauté de cet outil.

Ces résultats traduisent une double évolution : d’une part, l’intelligence artificielle est désormais capable de produire un raisonnement différentiel autonome d’un niveau comparable à celui d’un clinicien généraliste expérimenté ; d’autre part, elle améliore le raisonnement des médecins eux-mêmes lorsqu’elle s’intègre à leur processus cognitif.

La machine produit un raisonnement médical structuré

Au-delà des chiffres, cette étude met en évidence une évolution qualitative : la machine ne se contente plus d’associer des mots, elle produit un véritable raisonnement structuré. En analysant les « chaînes de pensée » générées par les modèles, les chercheurs observent une logique textuelle proche de celle d’un clinicien.

Lorsqu’un patient présente certains symptômes, l’IA relie ces informations à des causes connues, puis écarte ou retient des hypothèses selon la cohérence du tableau. Cette démarche reproduit fidèlement la structure d’un raisonnement clinique : extraction des faits pertinents, formulation d’hypothèses, confrontation aux données, élimination des incohérences, hiérarchisation et justification finale.

Cette capacité de l’IA à générer une argumentation progressive marque une avancée majeure : le modèle ne se limite plus à prédire des mots, il simule la délibération médicale, ce moment où le praticien met en balance plusieurs pistes avant de décider quel examen prescrire ou quelle hypothèse diagnostique retenir. Autrement dit, contrairement aux systèmes plus anciens, ces IA ne se contentent plus d’énumérer des diagnostics : elles expliquent pourquoi elles évoquent telle ou telle maladie et sur quels éléments repose leur raisonnement.

Des limites bien réelles : hallucinations et confabulations

Malgré des performances impressionnantes, les chercheurs restent prudents. L’IA n’a pas d’accès direct au patient : ni écoute, ni palpation, ni percussion, ni auscultation. Son raisonnement repose sur des textes, non sur la réalité vécue. Elle ne perçoit pas les nuances d’un examen clinique : elle raisonne à partir du langage, pas à partir du réel. Cette distance explique certaines erreurs récurrentes.

Les modèles peuvent produire des « hallucinations », c’est-à-dire des réponses entièrement inventées ou des « confabulations » qui déforment ou interprètent mal des informations exactes. Autrement dit, l’hallucination relève de la pure invention, tandis que la confabulation correspond à une erreur d’attribution ou à une distorsion de faits réels, comme par exemple citer correctement une phrase mais la rattacher à une mauvaise source.

Ces erreurs sont d’autant plus insidieuses qu’elles peuvent être formulées avec un naturel désarmant. Il faut garder à l’esprit que la fluidité du langage, aussi impressionnante soit-elle, ne garantit en rien la fiabilité du raisonnement médical. Les modèles d’IA peuvent en effet formuler des réponses avec une aisance déconcertante, rendant leur discours d’autant plus convaincant… même lorsqu’il est faux. Ce phénomène illustre ce que les chercheurs nomment l’illusion de compréhension : plus le modèle paraît sûr de lui, plus il devient difficile de repérer l’erreur, qu’il s’agisse d’un dosage médicamenteux erroné ou d’une confusion entre deux pathologies proches.

Dans un contexte clinique, une réponse inexacte mais énoncée avec assurance – ce qu’on appelle l’« excès de confiance du modèle » (model overconfidence) – peut facilement entraîner le clinicien dans une impasse diagnostique ou thérapeutique.

D’où la nécessité de dispositifs de contrôle rigoureux, soulignent des médecins et chercheurs en IA de l’université Stanford dans un éditorial publié en août 2025 dans Nature Medicine. Ils recommandent notamment d’imposer à ces systèmes des règles strictes, comme l’interdiction d’indiquer un dosage médicamenteux sans citer de recommandation officielle et sans qu’aucune formulation détournée ne permette de contourner ces garde-fous.

Au-delà de ces filtres, ces auteurs plaident pour que les modèles d’IA destinés à des usages médicaux sensibles – le diagnostic différentiel en fait partie – fonctionnent dans des environnements fermés, sécurisés, et accessibles uniquement à des professionnels habilités.

Publiée en août 2025 dans JAMA Network Open, une étude menée à l’université Stanford

a évalué six modèles de langage sur 68 questions médicales à choix multiples issues de la base MedQA. Les chercheurs ont eu une idée ingénieuse : remplacer la bonne réponse par « aucune des autres réponses ». Objectif : tester la capacité de raisonnement des IA, en comparant leurs performances avant et après cette manipulation, tout en les incitant à expliciter leur raisonnement (« chaîne de pensée »).

Les modèles testés étaient DeepSeek-R1, o3-mini, Claude 3.5 Sonnet, Gemini 2.0 Flash, GPT-4o et Llama 3.3-70B. Tous ont vu leur précision chuter, signe qu’ils reconnaissent des schémas plus qu’ils ne raisonnent vraiment. Même les plus performants, DeepSeek-R1 et o3-mini, ont enregistré des baisses significatives : respectivement 8,8 % et 16,1 % de réponses erronées après modification. Ces résultats montrent combien ces modèles perdent leurs repères dès que la formulation des questions s’écarte du cadre attendu.

« Lorsqu’ils sont contraints de raisonner en dehors des schémas de réponses familiers, tous

les modèles voient leur précision diminuer, ce qui remet en question l’idée selon laquelle l’intelligence artificielle serait prête pour une utilisation clinique autonome. Un système dont la précision passe de 80 % à 42 % face à une perturbation de schéma serait peu fiable dans un contexte clinique, où les présentations inédites sont fréquentes. Ces résultats suggèrent que ces systèmes sont plus fragiles que ne le laissent entendre leurs scores de référence », concluent les auteurs.

Il arrive aussi que les modèles accordent une importance excessive à un détail secondaire ou, inversement, omettent un symptôme essentiel, ce qui risque d’entraver la réflexion du médecin au lieu de l’améliorer.

« Compte tenu du risque que des informations trompeuses soient générées par les systèmes d’IA, y compris sous forme de dialogues convaincants, il est essentiel que les cliniciens en comprennent les limites fondamentales, sans perdre de vue leur rôle central dans la relation médecin-patient, ainsi que leur responsabilité ultime dans la prise en charge diagnostique et thérapeutique », rappellent les auteurs de l’étude.

Il importe de souligner que ces modèles d’IA reflètent les biais des données sur lesquelles ils ont été entraînés : ils privilégient les pathologies fréquentes et négligent les plus rares. Leur raisonnement, pour sophistiqué qu’il soit, demeure probabiliste et dépourvu d’intuition et d’expérience personnelle.

Les chercheurs rappellent aussi que, malgré des taux d’exactitude impressionnants – près de 30 % pour la top-1 accuracy et 60 % pour la top-10 accuracy -, des marges de progrès importantes subsistent, notamment dans les cas cliniques dépourvus de mots-clés évocateurs ou de signes pathognomoniques, ces indices caractéristiques d’une maladie particulière et permettant d’établir le diagnostic de certitude.

Enfin, dans la mesure où les cas étudiés ressemblent davantage à des casse-têtes médicaux qu’à des situations cliniques courantes, les auteurs recommandent d’évaluer ces modèles dans des contextes plus proches de la pratique réelle.

Un outil d’aide prometteur

Malgré ces limites, l’étude met en évidence le potentiel considérable des grands modèles de langage comme assistants du raisonnement médical. Des systèmes tels qu’AMIE pourraient élargir le champ du diagnostic différentiel, rappeler au médecin des causes rares ou suggérer des examens complémentaires. Ils constituent ainsi de véritables auxiliaires diagnostiques, capables d’enrichir la réflexion du praticien.

En améliorant la pertinence du diagnostic différentiel et en réduisant le temps de raisonnement, ces modèles pourraient trouver leur place comme outils d’aide à la décision, mais aussi dans la formation médicale. Leur usage pédagogique est en effet particulièrement prometteur : ils peuvent aider les étudiants à structurer leur démarche diagnostique en leur offrant un miroir textuel de leur propre raisonnement.

Bien que récent, l’usage d’AMIE n’a entraîné ni perte d’efficacité ni allongement du temps nécessaire à la résolution des cas cliniques, par rapport aux recherches classiques ou à d’autres sources d’information. Cela suggère que l’interface conversationnelle s’est révélée discrète et intuitive. Les cliniciens interrogés l’ont d’ailleurs unanimement jugée facile d’emploi et ont exprimé une opinion globalement favorable quant à ses usages et à ses implications.

Plusieurs facteurs expliquent la différence de performance observée entre AMIE utilisé seul et venant en appui auprès des cliniciens. D’une part, les praticiens ont tendance à s’ancrer sur leur première hypothèse diagnostique, même après interaction avec l’IA. D’autre part, l’intelligence artificielle peut être influencée par les questions du médecin, certains praticiens ayant remarqué qu’AMIE pouvait suivre des pistes non soutenues par les faits. Enfin, les médecins soulignent l’importance pour un outil comme AMIE de savoir exprimer clairement son incertitude. Cette capacité à formuler le doute serait déterminante pour les médecins dans la confiance accordée aux propositions de l’IA et dans la façon dont celles-ci sont intégrées dans leur raisonnement.

Cette étude marque un tournant dans la rencontre entre intelligence artificielle et médecine. En effet, à défaut de posséder l’intuition géniale du Dr Gregory House, l’IA ne se contente plus de réciter la médecine, elle commence à maîtriser le raisonnement médical. Le clinicien peut s’appuyer sur elle pour affiner son diagnostic différentiel et enrichir sa formation.

Quand l’IA apprend à dialoguer avec le médecin

Dans ce même numéro d’avril 2025 de Nature, une autre étude pousse la réflexion un cran plus loin. Là où la précédente démontrait la capacité d’une IA à raisonner comme un clinicien et à établir un diagnostic différentiel crédible, celle-ci introduit une avancée majeure : l’intelligence artificielle ne se contente plus de produire des listes d’hypothèses, elle apprend à dialoguer avec le médecin.

L’ambition est ici d’enseigner à la machine le sens même de l’échange médical : savoir poser les bonnes questions, reformuler, explorer plusieurs pistes diagnostiques au fil d’une conversation. Ce faisant, l’IA ne raisonne plus seulement : elle converse véritablement.

Pour évaluer cette nouvelle compétence de dialogue, les chercheurs de Google Research et Google DeepMind (Mountain View, Californie) ont mobilisé une version enrichie d’AMIE. Le modèle a été entraîné sur un vaste ensemble de données réelles comprenant des questions-réponses médicales à choix multiple, des raisonnements rédigés par des experts, des résumés de dossiers médicaux électroniques ainsi qu’une très large collection de conversations médicales transcrites.

Ce corpus rassemblait près de 99 000 transcriptions audio de consultations en présentiel, enregistrées sur dix ans aux États-Unis auprès de plus de mille cliniciens. Il couvrait 51 spécialités médicales – de la médecine générale à la rhumatologie, l’hématologie, l’oncologie, la médecine interne ou encore la psychiatrie – et 168 motifs de consultation, parmi lesquels le diabète de type 2, la polyarthrite rhumatoïde, l’asthme et la dépression figuraient parmi les plus courants. Pour renforcer son apprentissage, AMIE a également été exposé à 11 686 dialogues simulés couvrant 5 230 maladies distinctes. Cette diversité lui a permis d’élargir son spectre de raisonnement et d’acquérir une adaptabilité proche de celle d’un praticien expérimenté.

Vers une intelligence artificielle conversationnelle

C’est la dimension dialogique du raisonnement clinique que les chercheurs de Google DeepMind ont cherché à reproduire avec AMIE, leur projet d’intelligence artificielle médicale. Leur ambition : faire passer l’IA d’un rôle passif – répondre à des requêtes – à un rôle véritablement conversationnel, capable de dialoguer activement avec le médecin, et, à terme, avec le patient, pour co-construire le raisonnement diagnostique.

À la différence d’une consultation réelle, l’échange avec l’IA restait ici purement textuel : ni voix, ni langage corporel, donc sans les précieux indices non verbaux que les cliniciens observent habituellement. Les auteurs reconnaissent que cette absence constituait probablement un désavantage pour les médecins. Avant le début de l’évaluation, les praticiens avaient suivi deux séances pilotes de familiarisation avec l’interface textuelle synchrone, sans qu’il s’agisse d’une formation formelle ni d’un entraînement destiné à améliorer leurs performances.

L’expérimentation a mobilisé des médecins de trois pays (Canada, Royaume-Uni, Inde), ainsi qu’un panel d’évaluateurs spécialisés. Elle s’est appuyée sur 159 scénarios cliniques couvrant un large éventail de spécialités médicales. À noter : si la majorité des cas mettait en scène des patients atteints d’une maladie, une minorité concernait des personnes indemnes de pathologie, reflétant ainsi ce que l’on observe dans la vraie vie au quotidien.

Chaque interaction s’effectuait avec des comédiens (des patient-actors) formés à incarner des cas cliniques de façon standardisée. Le protocole, randomisé, en double aveugle et en crossover, garantissait une impartialité maximale : ni les évaluateurs ni les participants ne savaient s’ils échangeaient avec un médecin ou une IA, et l’ordre des consultations alternait de façon aléatoire.

Un diagnostic différentiel plus juste et étoffé avec AMIE

Les résultats sont sans équivoque : AMIE surpasse les médecins généralistes sur la majorité des critères de performance diagnostique. Ce modèle se montre plus précis, aussi bien pour le premier diagnostic proposé (top-1 accuracy) que pour les trois premiers (top-3 accuracy). Il identifie le bon diagnostic parmi les dix hypothèses formulées dans plus de 80 % des cas, un taux équivalent, voire supérieur, à celui des cliniciens humains. Ces derniers proposaient en moyenne cinq hypothèses, contre dix pour l’IA, ce qui traduit une approche plus exhaustive du diagnostic différentiel.

Sur les 149 cas portant sur des pathologies avérées, AMIE s’est montré supérieur aux généralistes dans la quasi-totalité des spécialités, à l’exception de l’obstétrique-gynécologie-urologie. Les écarts étaient particulièrement marqués en pneumologie et en médecine interne.

Une qualité de dialogue remarquée

Au-delà de la dimension purement diagnostique, AMIE s’est distingué par la qualité du dialogue instauré avec le patient-actor. Les médecins évaluateurs ont en effet noté chaque consultation selon une trentaine de critères : justesse du diagnostic, pertinence des recommandations, clarté, empathie, structuration du raisonnement, qualité des échanges, etc. Sur 32 critères évalués, l’IA a surpassé les cliniciens sur 30. Les chercheurs soulignent toutefois que ses réponses, souvent plus longues et mieux structurées, ont pu accentuer l’impression de maîtrise.

Fait marquant : dans plus de 60 % des cas, les évaluateurs humains ont préféré la conduite de l’entretien menée par AMIE, la jugeant plus fluide, cohérente et ciblée que celle des médecins.

Les patient-actors ont eux aussi évalué les échanges sur des dimensions telles que l’écoute, la clarté, le respect ou l’empathie. Là encore, l’IA devance les praticiens sur 25 des 26 critères.

Les performances d’AMIE, tant pour la qualité du diagnostic différentiel que pour celle de la conversation, reposaient sur une exigence particulière, compliquant singulièrement l’exercice : il ne s’agissait pas pour l’IA d’analyser des données déjà collectées, mais d’acquérir elle-même, au fil du dialogue, les informations cliniques pertinentes. Sa réussite dépendait donc autant de ses capacités de raisonnement que de son aptitude à mener un échange médical fluide et orienté vers le diagnostic.

L’IA raisonne en conversant, comme un généraliste dans son cabinet

Au-delà des chiffres, c’est la nature même du dialogue qui frappe. AMIE ne se contente pas d’énumérer des maladies possibles : il raisonne à voix haute. Il pose des questions ciblées : « Depuis quand la fièvre est-elle apparue ? », « Avez-vous voyagé récemment ? ». Il synthétise les informations recueillies et justifie ses choix en expliquant pourquoi il retient ou écarte certaines hypothèses.

Les chercheurs soulignent qu’AMIE a appris à reproduire la structure cognitive du raisonnement médical : formuler des hypothèses initiales, rechercher activement les données manquantes, puis ajuster son analyse au fur et à mesure que de nouvelles informations émergent. Cette approche conversationnelle rompt avec les modèles traditionnels d’intelligence artificielle centrés sur des réponses figées. Ici, la machine ne se contente plus de raisonner : elle raisonne en conversant, exactement comme un clinicien face à son patient.

Entre promesses et limites

Malgré ces performances impressionnantes, les chercheurs insistent sur deux limites majeures. AMIE n’a pas encore été testé en conditions réelles, face à de véritables patients. De plus, les dialogues de l’étude reposaient sur des scénarios simulés, ce qui ne permet pas de mesurer sa réaction face à la complexité émotionnelle et culturelle lors d’authentiques consultations médicales.

Comme tout grand modèle de langage, l’IA reste toujours sujette aux hallucinations : elle peut produire des affirmations erronées, mais formulées avec une grande assurance. Les auteurs mettent aussi en garde contre un excès de réalisme : plus l’échange semble naturel, plus le risque est grand que l’interlocuteur oublie qu’il s’agit d’une machine.

L’étude pointe enfin une autre limite de conception : la majorité des scénarios mettait en scène des patients effectivement malades, alors qu’un petit nombre concernait des individus en bonne santé. Or, dans la pratique quotidienne, le travail du clinicien consiste souvent à écarter l’hypothèse d’une maladie plutôt qu’à en diagnostiquer une.

Tao Tu, Mike Schaekermann, Alan Karthikesalingam, Vivek Natarajan et leurs collègues encouragent les futures études à « élargir l’éventail des cas vers une distribution plus équilibrée entre états pathologiques et non pathologiques, afin de mieux refléter la réalité clinique ».

L’égalité d’accès, prochain défi de l’IA médicale

Les auteurs insistent sur la nécessité de tester AMIE dans des contextes linguistiques, culturels et géographiques variés. Garantir une qualité de prise en charge équitable – qu’une consultation ait lieu en anglais, en français ou dans toute autre langue – demeure en effet un objectif essentiel.

La capacité d’une telle IA à fonctionner de manière fiable au sein de populations diverses constitue l’un des grands défis à relever pour bâtir une intelligence artificielle médicale véritablement responsable et accessible à tous.

L’IA conversationnelle, partenaire du raisonnement médical

Au total, cette étude marque une étape importante dans l’évolution de l’intelligence artificielle en santé. Après les outils d’aide à la décision et les modèles de diagnostic statistique, AMIE ouvre la voie à une IA médicale réellement conversationnelle : un partenaire du raisonnement clinique. Loin de remplacer l’entretien avec le patient, elle pourrait en devenir le prolongement intelligent : aider le médecin à structurer son interrogatoire, penser à des causes rares, ou générer un résumé diagnostique plus complet.

D’importantes étapes restent toutefois à franchir avant de voir un tel outil intégré à la pratique clinique. Il faudra en effet démontrer sa fiabilité, garantir la sécurité des patients et assurer la protection des données, celles des patients comme celles des médecins utilisateurs.

Les auteurs soulignent aussi la nécessité d’un encadrement éthique rigoureux avant tout déploiement. Cela suppose des évaluations approfondies dans divers contextes cliniques, ainsi que le développement de méthodes fiables permettant à l’IA d’estimer son propre degré d’incertitude et de laisser la décision finale à un expert humain. « Ces garde-fous sont indispensables pour éviter une dépendance excessive à l’égard des systèmes d’intelligence artificielle dans la prise de décision médicale », concluent-ils.

Futur binôme médecin-machine

En s’intégrant au cœur du raisonnement clinique, l’intelligence artificielle redéfinira sans doute, dans un futur proche, le rôle du médecin. L’IA assistera le clinicien en lui apportant une aide diagnostique dotée d’une mémoire étendue et d’une vitesse d’analyse inédite. Mais, espérons-le, ce sera toujours au médecin qu’il reviendra de relier les faits et parfois de déceler l’exception.

Entre raisonnement algorithmique et déduction humaine, le diagnostic différentiel pourrait ainsi devenir, dans bien des cas, un travail en binôme.

Pour en savoir plus :

Handler R, Sharma S, Hernandez-Boussard T. The fragile intelligence of GPT-5 in medicine. Nat Med. 2025 Oct 16. doi : 10.1038/s41591-025-04008-8

Dhaliwal G, Hood CM, Manrai AK, et al. Case 28-2025 : A 36-Year-Old Man with Abdominal Pain, Fever, and Hypoxemia. N Engl J Med. 2025 Oct 9 ;393(14) :1421-1434. doi : 10.1056/NEJMcpc2412539

McCoy LGn et al. Assessment of Large Language Models in Clinical Reasoning : A Novel Benchmarking Study. NEJM AI. 2025 ;2(10) : AIdbp2500120. doi : 10.1056/AIdbp2500120

Perlis R, Collins N. Can Open-Source AI Models Diagnose Complex Cases as Well as GPT-4? JAMA. 2025 May 6 ;333(17) :1473-1475. doi : 10.1001/jama.2025.2806

McDuff D, Schaekermann M, Tu T, et al. Towards accurate differential diagnosis with large language models. Nature. 2025 Apr 9. doi : 10.1038/s41586-025-08869-4

Tu T, Schaekermann M, Palepu A, et al. Towards conversational diagnostic artificial intelligence. Nature. 2025 Apr 9. doi : 10.1038/s41586-025-08866-7

Buckley TA, Riccardo Conci R, Brodeur PG, et al. Advancing Medical Artificial Intelligence Using a Century of Cases. [Submitted on 15 Sep 2025]

Goh E, Gallo RJ, Strong E, et al. GPT-4 assistance for improvement of physician performance on patient care tasks : a randomized controlled trial. Nat Med. 2025 Apr ;31(4) :1233-1238. doi : 10.1038/s41591-024-03456-y

Rodman A, Zwaan L, Olson A, Manrai AK. When it comes to benchmarks, humans are the only way. NEJM AI 2025 ;2(4) :AIe2500143. doi : 10.1056/AIe2500143

D’Adderio L, Bates DW. Transforming diagnosis through artificial intelligence. NPJ Digit Med. 2025 Jan 24 ;8(1) :54. doi : 10.1038/s41746-025-01460-1

Mao X, Huang Y, Jin Y, et al. A phenotype-based AI pipeline outperforms human experts in differentially diagnosing rare diseases using EHRs. NPJ Digit Med. 2025 Jan 28 ;8(1) :68. doi : 10.1038/s41746-025-01452-1

Schramm S, Preis S, Metz MC, et al. Impact of Multimodal Prompt Elements on Diagnostic Performance of GPT-4V in Challenging Brain MRI Cases. Radiology. 2025 Jan ;314(1) :e240689. doi : 10.1148/radiol.240689

Raji ID, Daneshjou R, Alsentzer E. It’s time to bench the medical exam benchmark. NEJM AI

2025 ;2(2) :AIe2401235. doi : 10.1056/AIe2401235

Zhou S, Lin M, Ding S, et al. Explainable differential diagnosis with dual-inference large language models. Npj Health Syst. 2025 ;2(1) :12. doi : 10.1038/s44401-025-00015-6

Chen X, Mao X, Guo Q, et al. RareBench : Can LLMs Serve as Rare Diseases Specialists ? arXiv :2402.06341. Jul 2024

Goh E, Gallo R, Hom J, et al. Large Language Model Influence on Diagnostic Reasoning : A Randomized Clinical Trial. JAMA Netw Open. 2024 Oct 1 ;7(10) :e2440969. doi : 10.1001/jamanetworkopen.2024.40969

Warrier A, Singh R, Haleem A, et al. The Comparative Diagnostic Capability of Large Language Models in Otolaryngology. Laryngoscope. 2024 Sep ;134(9) :3997-4002. doi : 10.1002/lary.31434

Milad D, Antaki F, Milad J, et al. Assessing the medical reasoning skills of GPT-4 in complex ophthalmology cases. Br J Ophthalmol. 2024 Sep 20 ;108(10) :1398-1405. doi : 10.1136/bjo-2023-325053

Barile J, Margolis A, Cason G, et al. Diagnostic Accuracy of a Large Language Model in Pediatric Case Studies. JAMA Pediatr. 2024 Mar 1 ;178(3) :313-315. doi : 10.1001/jamapediatrics.2023.5750

Yang X, Li T, Wang H, et al. Multiple large language models versus experienced physicians in diagnosing challenging cases with gastrointestinal symptoms. NPJ Digit Med. 2025 Feb 5 ;8(1) :85. doi : 10.1038/s41746-025-01486-5

Kim SH, Wihl J, Schramm S, et al. Human-AI collaboration in large language model-assisted brain MRI differential diagnosis : a usability study. Eur Radiol. 2025 Mar 7. doi : 10.1007/s00330-025-11484-6

Kim SH, Schramm S, Adams LC, et al. Benchmarking the diagnostic performance of open source LLMs in 1933 Eurorad case reports. NPJ Digit Med. 2025 Feb 12 ;8(1) :97. doi : 10.1038/s41746-025-01488-3

Shanmugam SK, Browning DJ. Comparison of Large Language Models in Diagnosis and Management of Challenging Clinical Cases. Clin Ophthalmol. 2024 Nov 12 ;18 :3239-3247. doi : 10.2147/OPTH.S488232

Milad D, Antaki F, Milad J, et al. Assessing the medical reasoning skills of GPT-4 in complex ophthalmology cases. Br J Ophthalmol. 2024 Sep 20 ;108(10) :1398-1405. doi : 10.1136/bjo-2023-325053

Khan MP, O’Sullivan ED. A comparison of the diagnostic ability of large language models in challenging clinical cases. Front Artif Intell. 2024 Aug 5 ;7 :1379297. doi : 10.3389/frai.2024.1379297

Shea YF, Lee CMY, Ip WCT, et al. Use of GPT-4 to Analyze Medical Records of Patients With Extensive Investigations and Delayed Diagnosis. JAMA Netw Open. 2023 Aug 1 ;6(8) :e2325000. doi : 10.1001/jamanetworkopen.2023.25000

Kanjee Z, Crowe B, Rodman A. Accuracy of a Generative Artificial Intelligence Model in a Complex Diagnostic Challenge. JAMA. 2023 Jul 3 ;330(1) :78-80. doi : 10.1001/jama.2023.8288

Ayers JW, Poliak A, Dredze M, et al. Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions Posted to a Public Social Media Forum. JAMA Intern Med. 2023 Jun 1 ;183(6) :589-596. doi : 10.1001/jamainternmed.2023.1838