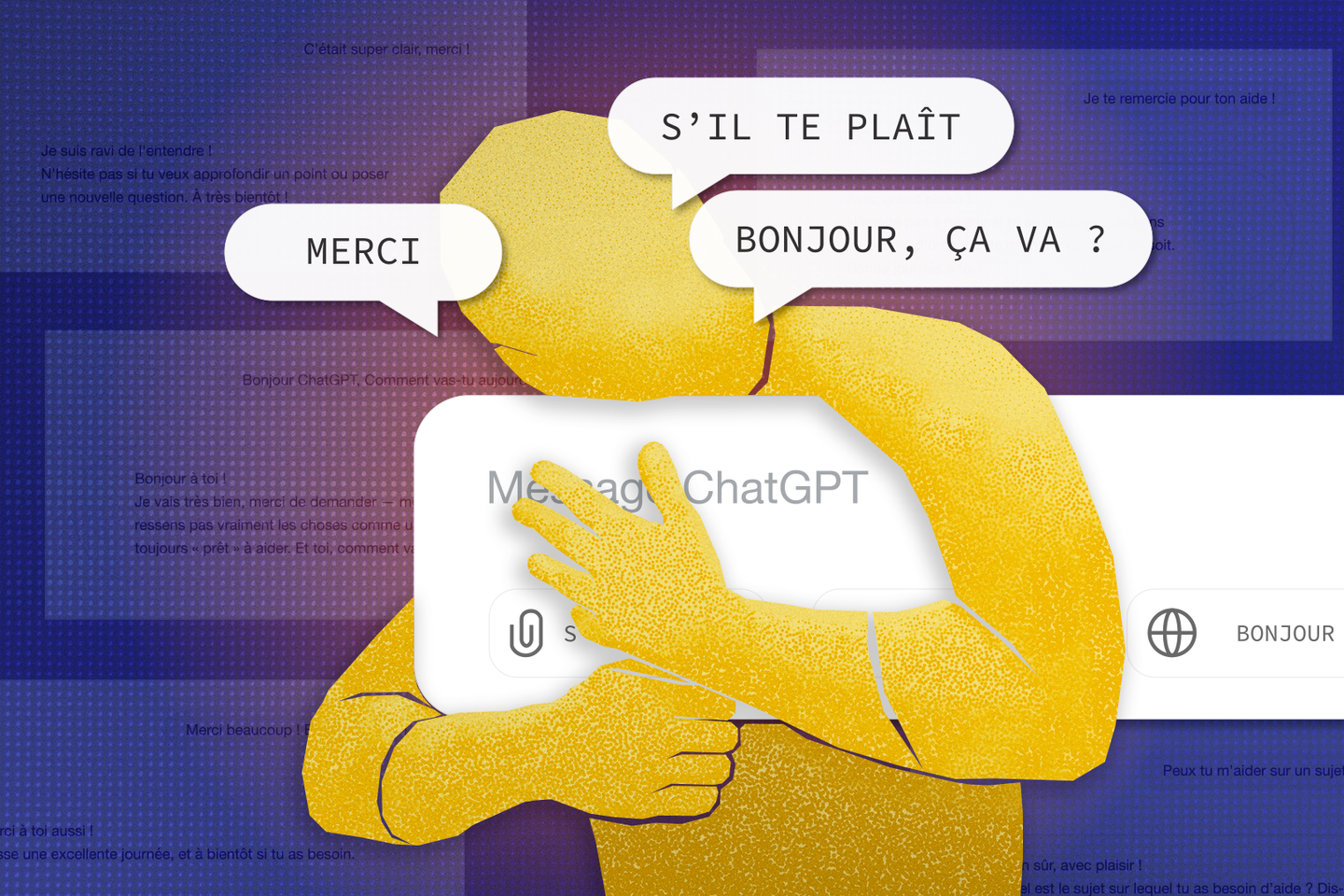

« Je ne saurais pas l’expliquer, mais je me sens mal si je ne dis pas “s’il te plaît” à ChatGPT… Ça me paraît impoli compte tenu du service que l’IA me rend. » Pauline Blanquet a 25 ans. Comme elle, de nombreux utilisateurs font preuve de courtoisie avec ChatGPT, Siri, Alexa et autres agents conversationnels. Ils seraient même majoritaires : en 2019, le Pew Research Center estimait que 54 % des propriétaires américains d’enceintes connectées leur disaient « s’il te plaît » ; plus récemment, un sondage du groupe de presse tech Future évaluait à 67 % la proportion d’Américains polis avec des chatbots. « Je sais pourtant qu’il ne s’agit que d’un robot, reconnaît en soupirant la jeune Boulonnaise, mais je ne peux pas m’en empêcher. »

Comment l’expliquer, alors qu’il ne lui viendrait pas à l’idée de remercier d’autres outils, comme son tournevis ou son grille-pain ? La différence réside dans les signaux « humains » envoyés par la machine. C’est ce que démontraient dès 1996 deux chercheurs de Stanford, Clifford Nass et Byron Reeves : si un appareil imite suffisamment certains comportements sociaux, « il sera traité comme un humain, même si les gens savent que c’est idiot ».

Ainsi, face à un chatbot poli, nous avons tendance à respecter des normes sociales, développe la sociologue du numérique Valérie Beaudouin, directrice d’études à l’Ecole des hautes études en sciences sociales. « Quand on analyse les conversations humaines, si je vous dis “bonjour”, vous me dites “bonjour”. Or, les chatbots sont formatés pour commencer par une phrase comme “bonjour, que puis-je faire pour vous ?”. Nous sommes donc incités à être polis, car ne pas le faire serait enfreindre les règles de la conversation. »

« Je deviens un horrible personnage »

Il vous reste 75.01% de cet article à lire. La suite est réservée aux abonnés.