Une législation encadrant l’usage des agents conversationnels, ou chatbots, qui font appel à l’intelligence artificielle (IA), a été adoptée, lundi 13 octobre, en Californie après une série de suicides d’adolescents ayant noué des relations intimes avec ces outils, ce qui est inédit aux Etats-Unis.

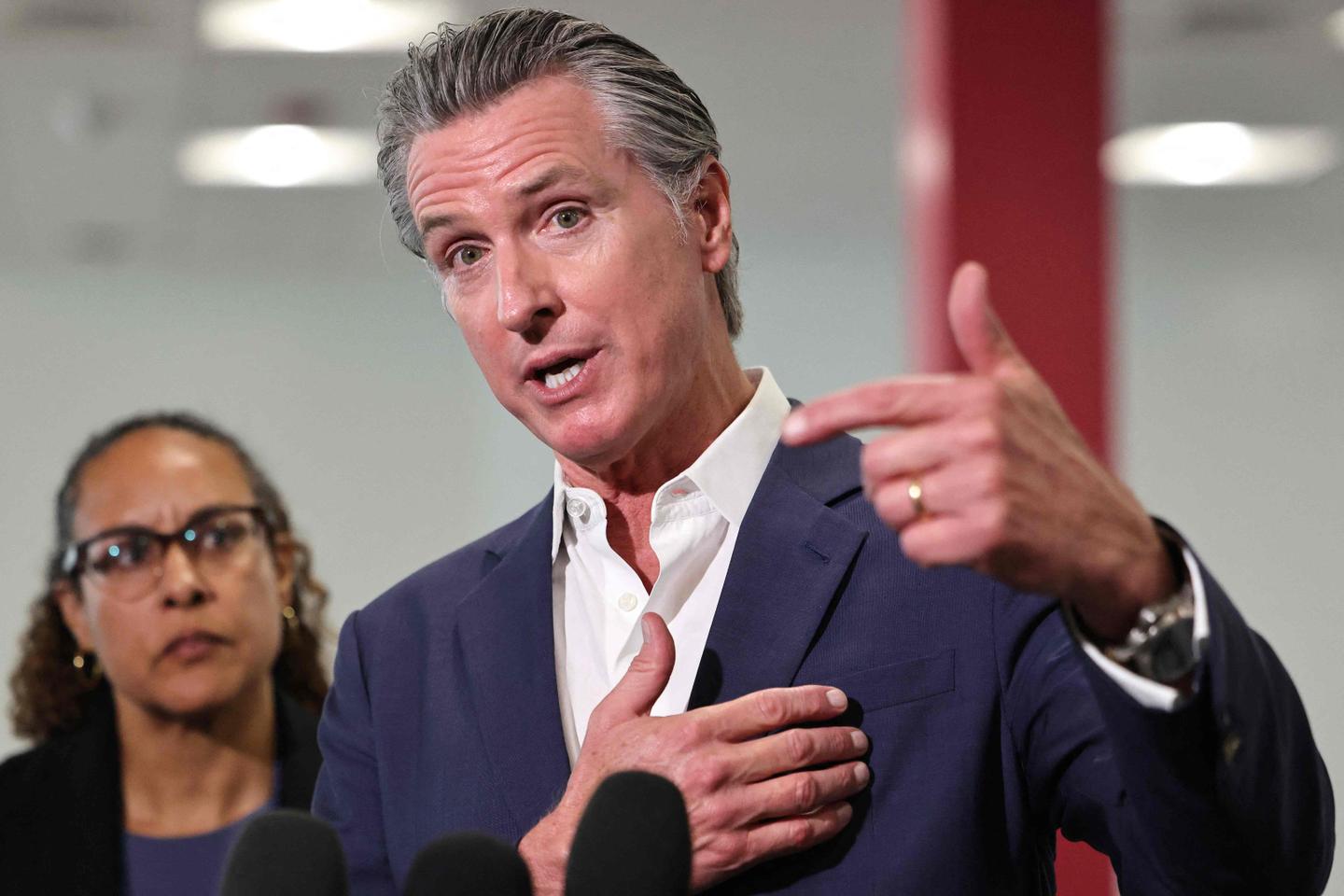

Malgré les pressions de la Maison-Blanche, qui s’oppose à la réglementation de l’IA, le gouverneur démocrate, Gavin Newsom, a promulgué une série de textes qui imposent, entre autres, de vérifier l’âge des utilisateurs, d’afficher des messages d’avertissement réguliers et de prévoir des protocoles de prévention du suicide.

« Nous avons vu des exemples vraiment horribles et tragiques de jeunes qui ont été victimes de technologies peu régulées, et nous ne resterons pas les bras croisés pendant que des entreprises exercent sans limites et sans rendre de comptes », dit-il dans un communiqué.

L’un des principaux textes, la loi SB243, concerne la réglementation des chatbots susceptibles de jouer un rôle de compagnon ou de confident, tels que ceux développés par des plateformes telles que Replika ou Character AI. Cette dernière a été poursuivie en justice par les parents d’un adolescent américain de 14 ans, prénommé Sewell, qui s’est suicidé en 2024 après avoir noué une relation amoureuse avec un chatbot inspiré de la série Game of Thrones.

« Agir de façon responsable »

« Nous pouvons continuer à être leader dans le domaine de l’IA (…) mais nous devons agir de façon responsable, en protégeant nos enfants tout au long du chemin », poursuit le gouverneur de Californie, où sont établis les principaux acteurs du développement de modèles d’IA, comme OpenAI (ChatGPT), Google (Gemini) ou xAI (Grok). « Les technologies émergentes comme les chatbots et les réseaux sociaux peuvent être source d’inspiration, éduquer et relier les gens mais, sans véritables garde-fous, elles peuvent aussi exploiter, égarer et mettre en danger nos enfants », ajoute-t-il.

Outre la vérification de l’âge, la loi impose aux entreprises d’afficher régulièrement – toutes les trois heures pour les mineurs – des messages pour rappeler à l’utilisateur que son interlocuteur est une machine, à prévoir une détection des idées suicidaires et à transmettre des statistiques sur le sujet aux autorités.

« L’industrie technologique est encouragée à capter l’attention des jeunes et à la retenir au détriment de leurs relations dans le monde réel », avait argué pendant les débats le sénateur californien Steve Padilla, à l’origine du texte.

Aux Etats-Unis, il n’existe pas de règles fédérales pour limiter les risques liés à l’IA et la Maison-Blanche essaie d’empêcher les Etats de produire leurs propres règles.