C’est l’histoire d’une jeune retraitée de Montcel (Savoie) qui peine à finaliser son dossier de pension auprès de sa caisse régionale. Elle dépose un commentaire négatif sur le site Services Publics + pour s’en plaindre. Un retour lui est fait un mois plus tard : « En cas de difficulté dans vos démarches, et si vous n’êtes pas parvenue à nous joindre, vous pouvez demander à être rappelée. » Le message est signé « Sylvie » et suivi de la mention « cette réponse a été générée par une IA (intelligence artificielle) à 83 % et vérifiée par un agent ».

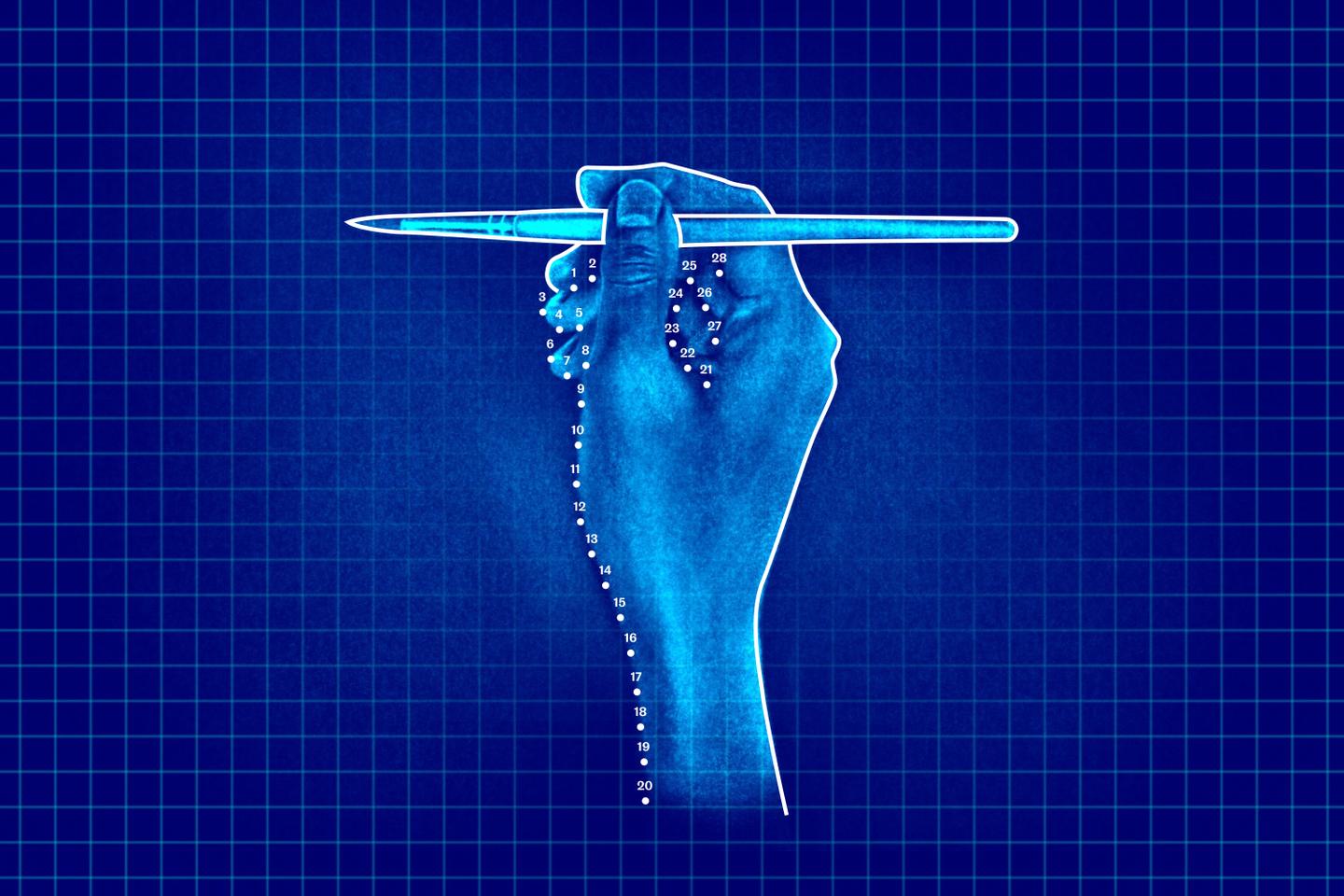

Les échanges de ce type entre l’administration et ses usagers sont devenus courants depuis l’irruption des IA génératives, il y a deux ans. Calcul des impôts, attribution des aides sociales, octroi des places en crèche… Des pans entiers des services publics utilisent désormais des algorithmes ou l’intelligence artificielle pour remplir leur mission. Ces innovations technologiques, conçues avec l’ambition de répondre plus vite et mieux aux besoins des citoyens, sont appelées à se multiplier au cours des années à venir. Mais elles peuvent poser des problèmes si elles ne sont pas correctement encadrées, prévient un rapport de la Défenseure des droits publié mercredi 13 novembre.

Un risque de déresponsabilisation

Le document appelle notamment à conserver un contrôle humain des systèmes automatisés, pour « garder la main » sur des décisions importantes. Les auteurs jugent nécessaire de s’assurer que les systèmes respectent le droit dès leur conception, et tout au long de leur utilisation, par le biais des contrôles réguliers. Les algorithmes d’apprentissage automatique, qui s’adaptent d’eux-mêmes au fil du temps, induisent par exemple un risque accru d’erreur, de biais et de discrimination.

Plusieurs textes français et européens posent en principe des garde-fous à l’usage des algorithmes, notamment la garantie d’interventions humaines. Mais la pratique fait apparaître certaines dérives. Le rapport cite Affelnet, la procédure d’affectation des élèves après leur classe de 3e. L’outil utilise différents critères, dont les résultats scolaires, pour attribuer des points à chaque élève de manière automatisée. Or, la Défenseure des droits explique avoir été saisie du cas d’un élève qui semble avoir été traité de manière totalement informatisée. Seules des notes de 0 apparaissaient dans la catégorie « évaluations » de son dossier, « sans que le caractère exceptionnel de cette donnée amène la commission à procéder à des vérifications ».

Il vous reste 51.12% de cet article à lire. La suite est réservée aux abonnés.